Você só precisa de atenção! Qual é o trabalho mais importante da inteligência artificial?

O artigo da Google que revolucionou as técnicas de inteligência artificial e está por trás de várias ferramentas importantes.

Estamos entrando em uma era onde a inteligência artificial está ficando cada vez mais presentes nas nossas vidas. Desde sistemas de recomendações em vários sites até aplicações como o ChatGPT. Isso aconteceu principalmente por causa do avanço da inteligência artificial e de toda tecnologia envolvida tanto em questões de técnicas quanto em questões de hardwares.

Um dos principais motivos desse avanço está na área de NLP ou natural language processing com os modelos de linguagem em larga escala ou LLMs. Esses sistemas nasceram com intuito de gerar textos enquanto usam dados para treinar a compreensão e a geração de textos. Eles são usados em ferramentas como o ChatGPT e o Gemini que conseguem responder perguntas e realizar tarefas.

Em 2017, a Google publicou o artigo "Attention Is All You Need" que introduziu uma arquitetura chamada Transformer. A arquitetura possui um mecanismo chamado atenção que o modelo consegue “prestar atenção” e observar padrões e relações em textos e imagens. Recentemente, a OpenAI anunciou o o3 que usa como base Transformers em seu algoritmo mas o que são Transformers? E como o artigo da Google mudou o mundo?

Attention is All You Need

O artigo "Attention Is All You Need" foi publicado em 2017 por um grupo de pesquisadores da Google. O artigo trouxe, pela primeira vez, a arquitetura chamada Transformer para uso em NLP e problemas que envolviam sequências. Por trás da Transformer, a Google inseriu um mecanismo chamado mecanismo de atenção.

A arquitetura foi testada em diversas tarefas como, por exemplo, tradutores de uma língua para outra onde entender sequência e relação é fundamental. Com o tempo, a ideia de Transformer foi sendo expandida para images e até vídeos. Porém, o uso mais conhecido e popular dessa arquitetura está nos modelos de linguagem em larga escala ou LLM que são treinados em uma grande quantidade de dados.

Attention

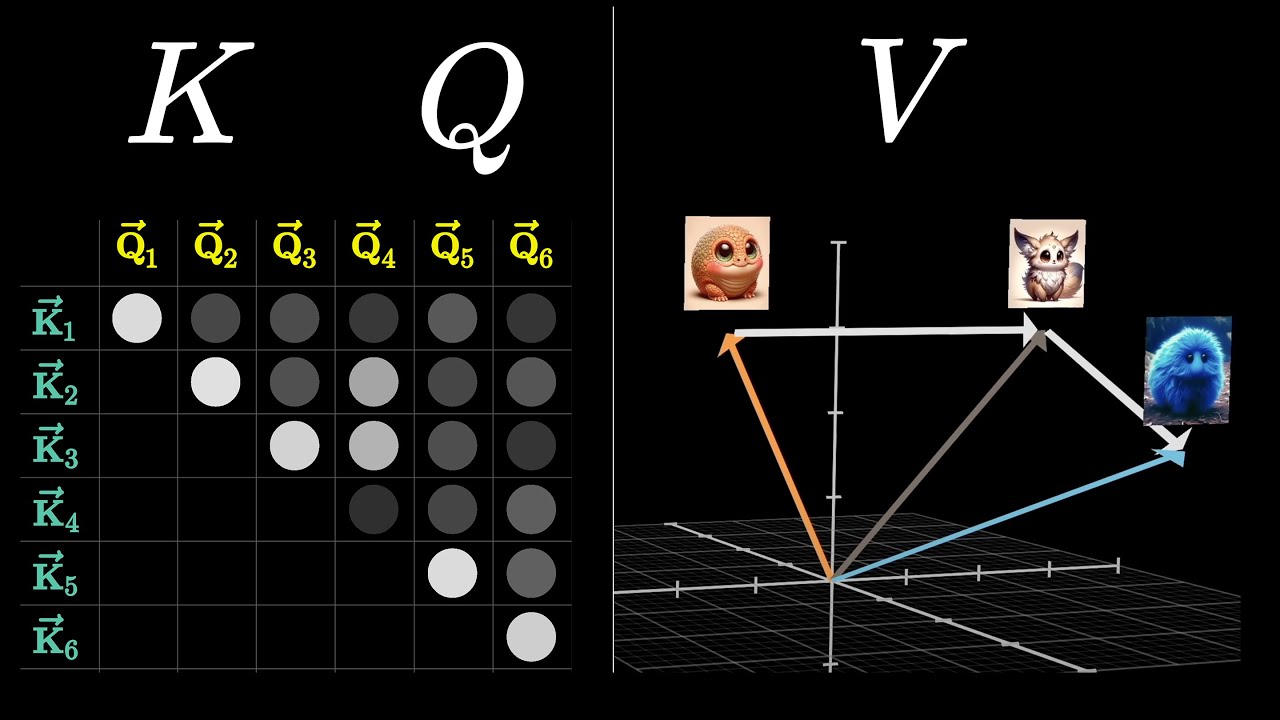

Dentro da Transformer, o mecanismo chamado de Attention ou mecanismo de atenção é a parte mais importante no artigo. Ele funciona de forma a focar nas partes mais relevantes dos dados através de operações matemáticas. Um exemplo é que esses mecanismos de atenção fazem o modelo pegar as palavras mais importantes de uma frase ou texto. Assim, as previsões dependem das partes mais relevantes.

Esse mecanismo atribui pesos a cada elemento de uma sequência de entrada e dependendo da tarefa a ser realizada, calula-se a relevância. Os pesos são calculados por meio de operações entre vetores fazendo com que alcance elementos distantes na mesma sequência. Outro exemplo é a self-attention que é usado para capturar relações como dependências entre palavras em uma frase.

Transformers

E as Transformers se utilizam justamente dos mecanismos de atenção que inspirou o nome do artigo "Attention Is All You Need". Ela é composta por duas partes: o encoder e o decoder. O encoder processa a entrada e cria representações internas que são importantes para a rede. Já o decoder pega essas representações e gera saídas.

Cada parte da Transformer é composta por várias camadas como as camadas de Self-Attention e camadas de redes neurais. Essas camadas se combinam de forma a aprender relações diferentes nos dados desde relações locais até relações mais gerais. O mecanismo de atenção no Transformer faz com que grandes volumes de dados sejam processados simultaneamente.

Aplicações

As aplicações das Transformers são inúmeras e estão cada vez mais presentes no dia a dia. Um exemplo é o ChatGPT da OpenAI que ateu recordes de mais usuários utilizando em 1 dia. Além do ChatGPT, o Gemini da Google e o Llama do Meta também se baseiam em Transformers para gerar textos que dependem da entrada dada pelo usuário. Geradores de imagens e vídeos também já estão sendo usados como o Grok 2 do X.

Recentemente, a OpenAI anunciou o modelo o3 que é capaz de realizar tarefas mais complexas e é conhecida como modelo de raciocínio. O o3 é baseado no o1 que foi lançado em setembro de 2024. Ambos os modelos, chamados de modelos de raciocínio, dependem de Transformers junto com outros algoritmos como aprendizado por reforço.

Referência da notícia

Vaswani et al. 2017 Attention Is All You Need Google